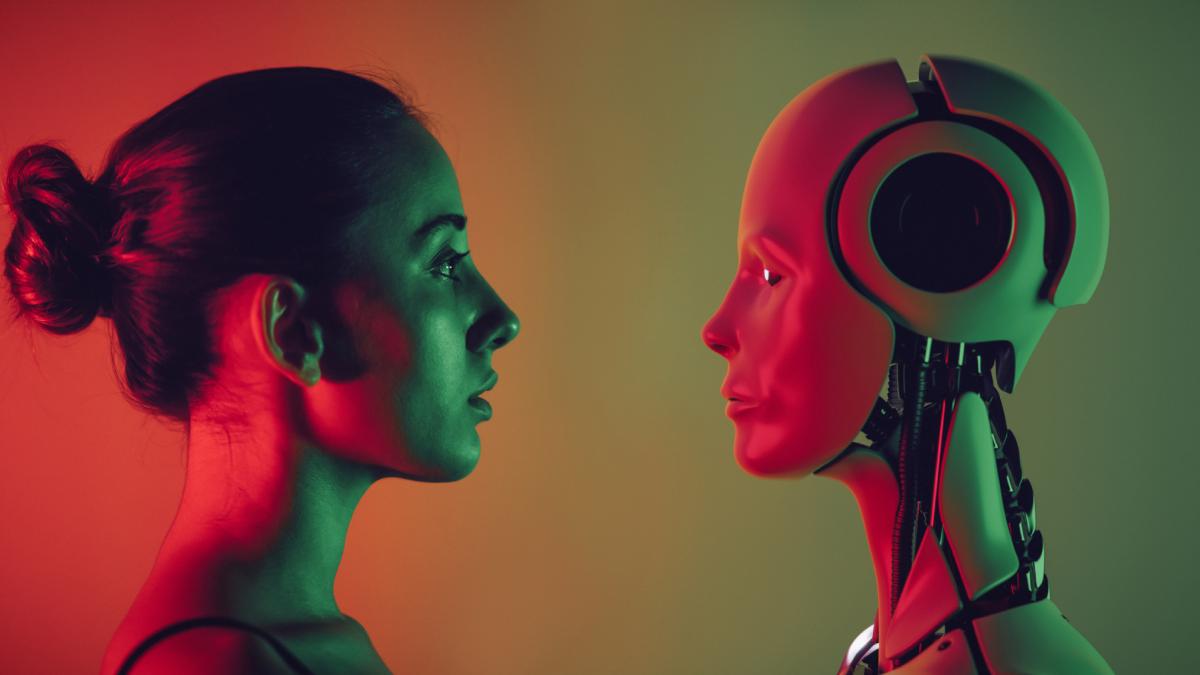

Știm că inteligența artificială (AI) nu poate gândi la fel ca o persoană, dar o nouă cercetare a dezvăluit modul în care această diferență ar putea afecta procesul decizional al AI, ducând la ramificații în lumea reală pentru care oamenii ar putea fi nepregătiți, potrivit Live Science.

Studiul, publicat în februarie 2025 în revista Transactions on Machine Learning Research, a examinat cât de bine modelele lingvistice mari (LLM) pot forma analogii.

Ei au constatat că, atât în analogiile simple cu șiruri de litere, cât și în problemele matricei digitale - în care sarcina era de a completa o matrice prin identificarea cifrei lipsă - oamenii au performat bine, dar performanța AI a scăzut brusc.

În timp ce testau robustețea oamenilor și a modelelor AI pe probleme de analogie bazate pe povești, studiul a constatat că modelele erau susceptibile la efectele ordinii răspunsurilor - diferențe în răspunsuri datorate ordinii tratamentelor într-un experiment - și, de asemenea, este posibil să fi fost mai predispuse la parafrazare.

Modelelor AI le lipsesc abilitățile de învățare „zero-shot”

În ansamblu, studiul a concluzionat că modelelor AI le lipsesc abilitățile de învățare „zero-shot”, în care un cursant observă eșantioane din clase care nu au fost prezente în timpul instruirii și face predicții cu privire la clasa din care fac parte în funcție de întrebare.

Coautorul studiului, Martha Lewis, profesor asistent de inteligență artificială neuro-simbolică la Universitatea din Amsterdam, a dat un exemplu în care inteligența artificială nu poate efectua raționamente analogice la fel de bine ca oamenii în probleme cu șiruri de litere.

„Analogiile șirurilor de litere au forma „dacă abcd merge la abce, la ce merge ijkl?”. Majoritatea oamenilor vor răspunde 'ijkm', iar AI tinde să dea și acest răspuns”, a declarat Lewis pentru Live Science. „Dar o altă problemă ar putea fi 'dacă abbcd merge la abcd, la ce merge ijkkl? Oamenii vor tinde să răspundă 'ijkl' - modelul este de a elimina elementul repetat. Dar GPT-4 tinde să rezolve greșit probleme precum acestea.”

De ce este important că AI nu poate gândi ca oamenii

Lewis a spus că, în timp ce noi putem face abstracție de la modele specifice la reguli mai generale, LLM-urile nu au această capacitate. „Ele sunt bune la identificarea și potrivirea tiparelor, dar nu și la generalizarea pornind de la aceste tipare.”

Majoritatea aplicațiilor AI se bazează într-o anumită măsură pe volum - cu cât sunt disponibile mai multe date de instruire, cu atât sunt identificate mai multe modele. Dar Lewis a subliniat că potrivirea tiparelor și abstractizarea nu sunt același lucru. „Este vorba mai puțin despre ceea ce se află în date și mai mult despre modul în care datele sunt utilizate”, a adăugat ea.

Pentru a da o idee despre implicații, inteligența artificială este utilizată din ce în ce mai mult în domeniul juridic pentru cercetare, analiza jurisprudenței și recomandări privind sentințele. Dar, având o capacitate redusă de a face analogii, este posibil să nu reușească să recunoască modul în care precedentele juridice se aplică unor cazuri ușor diferite atunci când acestea apar.

Având în vedere că această lipsă de robustețe ar putea afecta rezultatele din lumea reală, studiul a subliniat că acest lucru a servit drept dovadă că trebuie să evaluăm cu atenție sistemele de inteligență artificială nu doar pentru acuratețe, ci și pentru robustețea capacităților lor cognitive.