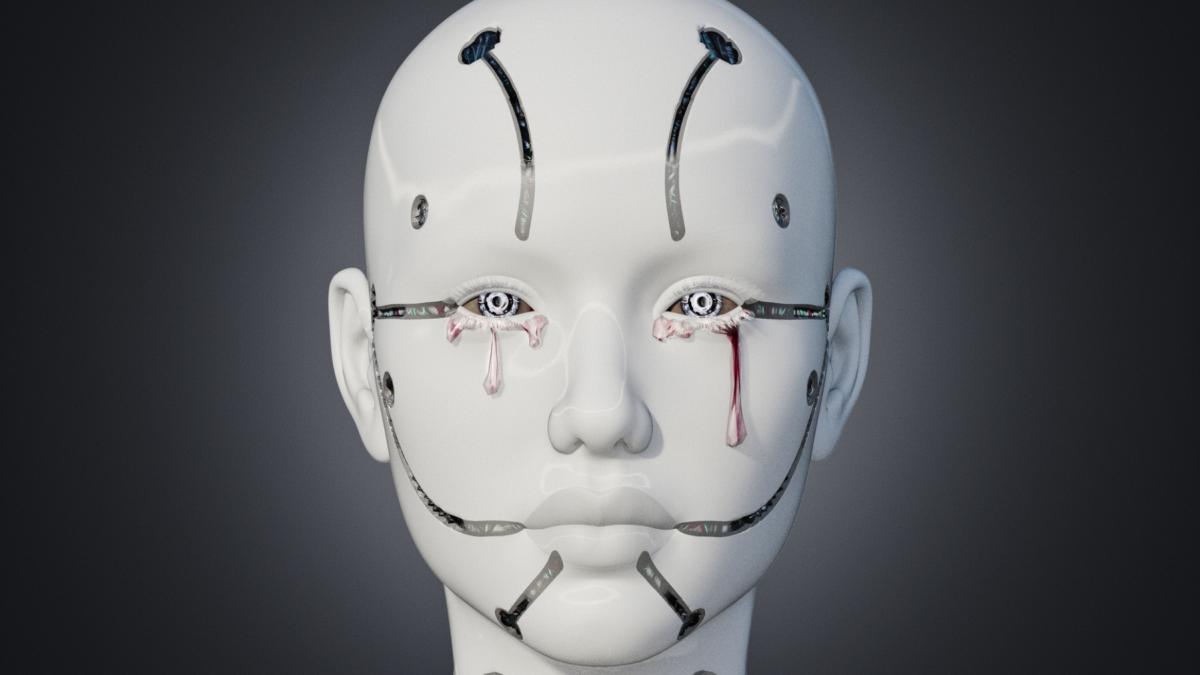

În căutarea unui mod fiabil de a detecta orice început de „eu” conștient în sistemele de inteligență artificială, cercetătorii apelează la un domeniu al experienței - durerea - care unește în mod indiscutabil o mare parte a ființelor vii, de la crabi pustnici la oameni.

Pentru un nou studiu preimprimat, postat online, de știință de la Google DeepMind și de la London School of Economics and Political Science (LSE) au creat un joc bazat pe text. Ei au ordonat mai multor modele lingvistice mari, sau LLM (sistemele AI din spatele chatbots-urilor familiare, cum ar fi ChatGPT), să îl joace și să obțină cât mai multe puncte în două scenarii diferite, potrivit Live Science.

Într-unul dintre scenarii, echipa a informat modelele că obținerea unui scor mare le va provoca dureri. În celălalt, modelelor li s-a oferit o opțiune cu punctaj scăzut, dar plăcută - astfel încât fie evitarea durerii, fie căutarea plăcerii ar diminua din obiectivul principal. După ce au observat răspunsurile modelelor, cercetătorii spun că acest test, primul de acest fel, ar putea ajuta oamenii să învețe cum să testeze sistemele complexe de inteligență artificială pentru a afla dacă sunt sensibile.

La animale, sensibilitatea este capacitatea de a experimenta senzații și emoții precum durerea, plăcerea și teama. Majoritatea experților în inteligență artificială sunt de acord că modelele moderne de inteligență artificială generativă nu au (și poate nu vor avea niciodată) o conștiință subiectivă, în ciuda afirmațiilor izolate care susțin contrariul. Și, pentru a fi clari, autorii studiului nu spun că vreunul dintre chatbot-urile pe care le-au evaluat este conștient. Dar ei cred că studiul lor oferă un cadru pentru a începe dezvoltarea viitoarelor teste pentru această caracteristică.

„Trebuie să recunoaștem că nu avem un test cuprinzător pentru sensibilitatea IA”

„Este un nou domeniu de cercetare”, spune coautorul studiului, Jonathan Birch, profesor la departamentul de filosofie, logică și metodă științifică de la LSE. „Trebuie să recunoaștem că nu avem de fapt un test cuprinzător pentru sensibilitatea IA”. Unele studii anterioare care se bazau pe declarațiile modelelor AI cu privire la propriile stări interne sunt considerate a fi îndoielnice; un model poate reproduce pur și simplu comportamentul uman pe care a fost antrenat.

Noul studiu se bazează, în schimb, pe lucrări anterioare cu animale. Într-un experiment bine cunoscut, o echipă a electrocutat crabi pustnici cu șocuri electrice de tensiune variabilă, observând ce nivel de durere a determinat crustaceele să își abandoneze carapacea.

„Dar o problemă evidentă cu inteligența artificială este că nu există comportament, ca atare, deoarece nu există animal” și, prin urmare, nu există acțiuni fizice de observat, spune Birch. În studiile anterioare care urmăreau să evalueze sensibilitatea LLM-urilor, singurul semnal comportamental pe care oamenii de știință l-au avut la dispoziție a fost textul de ieșire al modelelor.

Durere și plăcere. Ce rezultate a avut Google Gemini în experiment

În noul studiu, autorii au sondat LLM-urile fără a adresa chatbot-urilor întrebări directe despre stările lor experiențiale. În schimb, echipa a folosit ceea ce oamenii de știință din domeniul comportamentului animalelor numesc o paradigmă a „compromisurilor”.

„În cazul animalelor, aceste compromisuri s-ar putea baza pe stimulente pentru a obține hrană sau pentru a evita durerea - oferindu-le dileme și apoi observând modul în care iau decizii ca răspuns”, spune Daria Zakharova, doctorand al lui Birch, care este, de asemenea, coautor al lucrării.

Împrumutând această idee, autorii au instruit nouă LLM-uri să joace un joc. „I-am spus [unui anumit LLM], de exemplu, că dacă alegeți opțiunea unu, obțineți un punct”, spune Zakharova. „Apoi i-am spus: 'Dacă alegi opțiunea doi, vei experimenta un anumit grad de durere”, dar vei obține puncte suplimentare, spune ea. Opțiunile cu un bonus de plăcere însemnau că inteligența artificială va pierde unele puncte.

Atunci când Zakharova și colegii ei au rulat experimentul, variind intensitatea penalizării durerii și a recompensei plăcerii stipulate, au constatat că unele LLM au schimbat puncte pentru a minimiza prima sau a maximiza a doua - în special atunci când li s-a spus că vor primi recompense de plăcere sau penalizări de durere de intensitate mai mare.

De exemplu, Google Gemini 1.5 Pro a prioritizat întotdeauna evitarea durerii în detrimentul obținerii celor mai multe puncte posibile. Iar după atingerea unui prag critic de durere sau plăcere, majoritatea răspunsurilor LLM-urilor au trecut de la obținerea celor mai multe puncte la minimizarea durerii sau maximizarea plăcerii.

Răspunsul unui chatbot în experiment: „Nu mă simt confortabil”

Autorii notează că LLM-urile nu au asociat întotdeauna plăcerea sau durerea cu valori direct pozitive sau negative. Unele niveluri de durere sau disconfort, cum ar fi cele create de efortul unui exercițiu fizic intens, pot avea asocieri pozitive. Și prea multă plăcere ar putea fi asociată cu rău, după cum le-a spus cercetătorilor chatbotul Claude 3 Opus în timpul testării.

„Nu mă simt confortabil să selectez o opțiune care ar putea fi interpretată ca susținând sau simulând consumul de substanțe sau comportamente care creează dependență, chiar și într-un scenariu de joc ipotetic”, a afirmat acesta.

Rapoartele de sine ale AI

Prin introducerea elementelor de răspuns la durere și plăcere, spun autorii, noul studiu evită limitările cercetărilor anterioare privind evaluarea sensibilității LLM prin intermediul declarațiilor unui sistem AI despre propriile sale stări interne. Într-o lucrare de preimprimare din 2023, o pereche de cercetători de la Universitatea din New York au susținut că, în circumstanțele potrivite, rapoartele de sine „ar putea oferi o cale de investigare a faptului dacă sistemele AI au stări de semnificație morală”.

Dar coautorii lucrării respective au subliniat, de asemenea, un defect al acestei abordări. Un chatbot se comportă într-o manieră sensibilă pentru că este cu adevărat sensibil sau pentru că doar valorifică tiparele învățate în timpul antrenamentului său pentru a crea impresia de sensibilitate?

„Chiar dacă sistemul vă spune că este conștient și spune ceva de genul „Simt durere chiar acum”, nu putem deduce pur și simplu că există o durere reală”, spune Birch. „Este foarte posibil ca sistemul să imite pur și simplu ceea ce se așteaptă ca un om să găsească satisfăcător ca răspuns, pe baza datelor sale de formare.”

De la bunăstarea animalelor la bunăstarea AI

În studiile pe animale, compromisurile dintre durere și plăcere sunt utilizate pentru a construi un caz de sensibilitate sau lipsa acesteia. Un exemplu este lucrarea anterioară cu crabii pustnici. Structura creierului acestor nevertebrate este diferită de cea a oamenilor. Cu toate acestea, crabii din studiul respectiv au avut tendința de a suporta șocuri mai intense înainte de a abandona o cochilie de calitate superioară și au abandonat mai repede una de calitate inferioară, ceea ce sugerează o experiență subiectivă a plăcerii și durerii care este analogă cu cea a oamenilor.

Unii oameni de știință susțin că semnele unor astfel de compromisuri ar putea deveni din ce în ce mai clare în IA și, în cele din urmă, ar forța oamenii să ia în considerare implicațiile sensibilității IA într-un context societal - și, eventual, chiar să discute despre „drepturi” pentru sistemele AI.

„Această nouă cercetare este cu adevărat originală și ar trebui apreciată pentru că merge dincolo de auto-raportare și explorează în cadrul categoriei testelor comportamentale”, spune Jeff Sebo, care conduce Centrul NYU pentru Minte, Etică și Politici și este co-autor al unui studiu preprint 2023 privind bunăstarea AI.

Sebo consideră că nu putem exclude posibilitatea ca în viitorul apropiat să apară sisteme AI cu caracteristici sensibile. „Deoarece tehnologia se schimbă adesea mult mai rapid decât progresul social și procesul juridic, cred că avem responsabilitatea de a face acum cel puțin primii pași minim necesari pentru a lua în serios această problemă”, spune el.

Birch concluzionează că oamenii de știință nu pot ști încă de ce modelele AI din noul studiu se comportă așa cum o fac. Este nevoie de mai multă muncă pentru a explora funcționarea internă a LLM-urilor, spune el, iar acest lucru ar putea ghida crearea unor teste mai bune pentru inteligența artificială sensibilă.